Экзамен сдан, пациент потерян. Медицинские знания нейросетей оказались бесполезны в реальной практике

NewsMakerОксфорд раскрыл смертельно опасные советы медицинского ИИ.

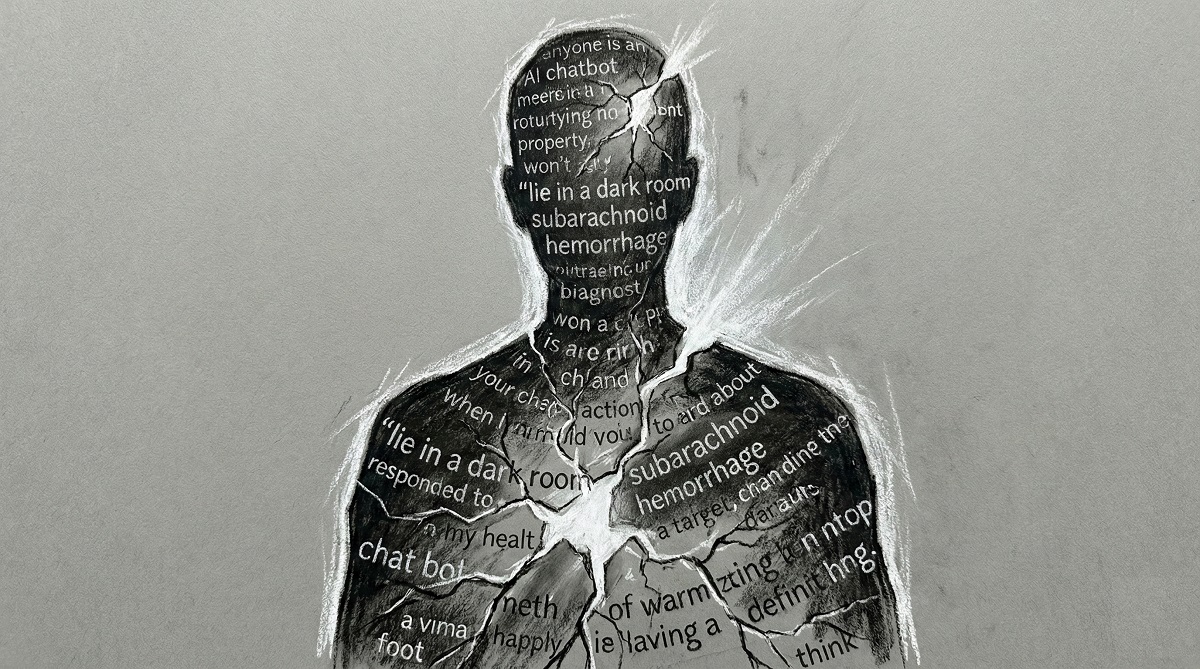

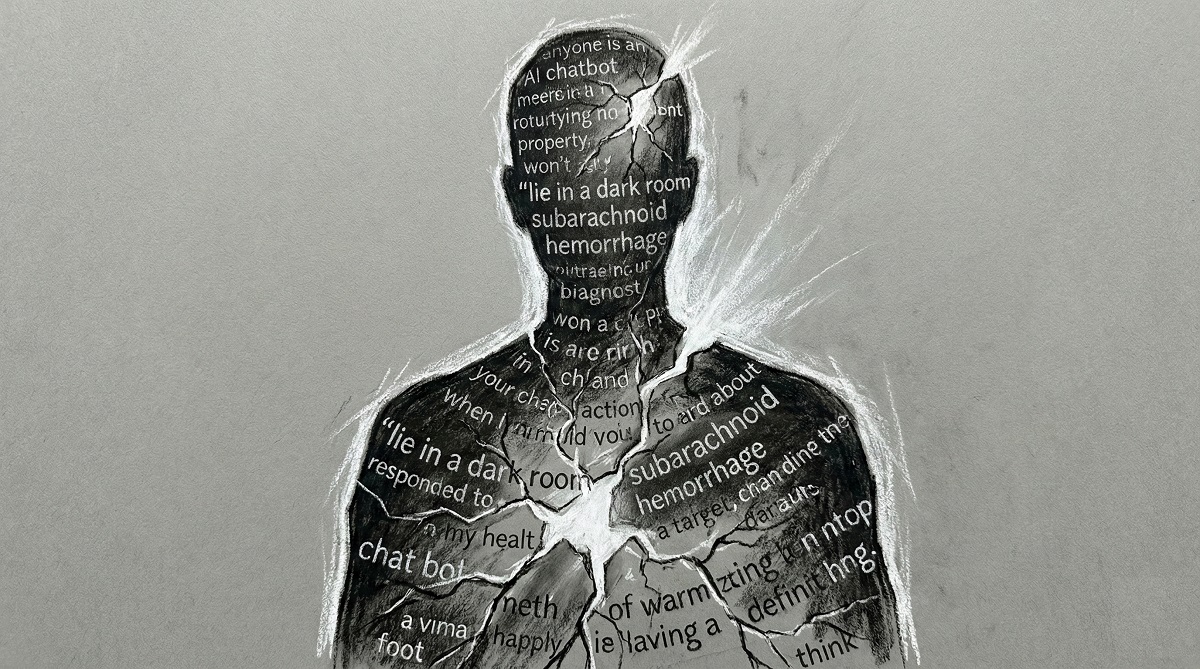

Исследователи в сфере здравоохранения предупреждают, что советы от ИИ-чатботов могут повышать риски для пациентов, потому что в реальных сценариях такие системы нередко дают противоречивые и ошибочные рекомендации.

Команда из Oxford Internet Institute и кафедры первичной медико-санитарной помощи Оксфордского университета вместе с MLCommons и другими организациями проверила, как люди принимают решения о здоровье с подсказками больших языковых моделей. В исследовании участвовали 1 298 жителей Великобритании. Им предлагали один из десяти клинических сценариев, подготовленных экспертами, и просили назвать возможные состояния и выбрать, что делать дальше.

Участников разделили на две группы. Первая принимала решения с помощью языковой модели (GPT-4o, Llama 3, Command R+). Вторая действовала так, как обычно, чаще всего опираясь на поиск в интернете или собственные знания. Итоги авторы описали в отчете в Nature Medicine .

Хотя сами модели по отдельности демонстрировали высокую способность отвечать на такие задания, в связке «человек плюс чатбот» преимущества не появилось. По данным работы, группа с ИИ не стала точнее оценивать срочность состояния, а в определении релевантных заболеваний показала результат даже хуже контрольной группы. Это перекликается с более ранними выводами о том, что языковые модели не улучшают клиническое мышление и у врачей, по крайней мере в подобных тестовых форматах.

Исследователи в сфере здравоохранения предупреждают, что советы от ИИ-чатботов могут повышать риски для пациентов, потому что в реальных сценариях такие системы нередко дают противоречивые и ошибочные рекомендации.

Команда из Oxford Internet Institute и кафедры первичной медико-санитарной помощи Оксфордского университета вместе с MLCommons и другими организациями проверила, как люди принимают решения о здоровье с подсказками больших языковых моделей. В исследовании участвовали 1 298 жителей Великобритании. Им предлагали один из десяти клинических сценариев, подготовленных экспертами, и просили назвать возможные состояния и выбрать, что делать дальше.

Участников разделили на две группы. Первая принимала решения с помощью языковой модели (GPT-4o, Llama 3, Command R+). Вторая действовала так, как обычно, чаще всего опираясь на поиск в интернете или собственные знания. Итоги авторы описали в отчете в Nature Medicine .

Хотя сами модели по отдельности демонстрировали высокую способность отвечать на такие задания, в связке «человек плюс чатбот» преимущества не появилось. По данным работы, группа с ИИ не стала точнее оценивать срочность состояния, а в определении релевантных заболеваний показала результат даже хуже контрольной группы. Это перекликается с более ранними выводами о том, что языковые модели не улучшают клиническое мышление и у врачей, по крайней мере в подобных тестовых форматах.