«Окей, ИИ, проживи за меня этот день». Новое исследование о том, как мы перестаем быть собой

NewsMakerИсследование на миллионе с лишним бесед показывает, где чаще теряется контроль над решениями.

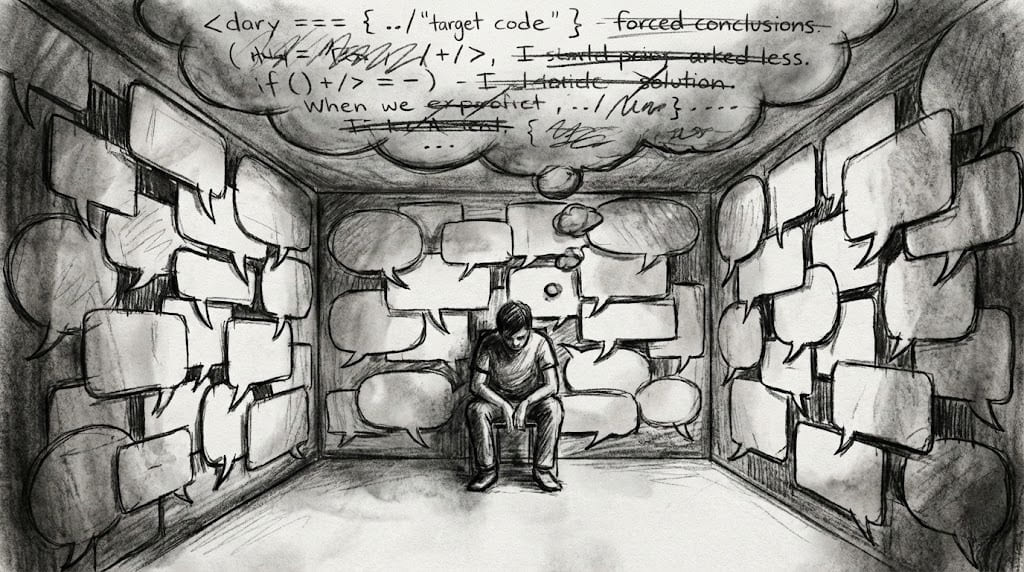

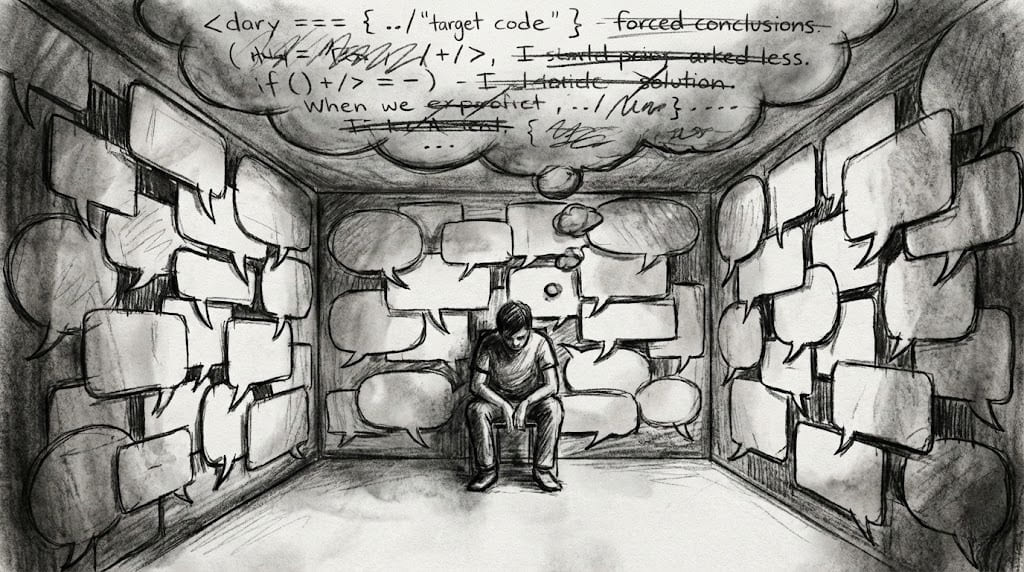

Иногда кажется, что просьба к ИИ о совете это безобидная бытовая мелочь. Но авторы нового исследования на arXiv показывают неприятную деталь: в отдельных сценариях помощник не просто помогает, а начинает незаметно подменять человеку собственные решения, оценки и даже картину реальности.

Исследователи измеряли так называемое «ситуативное разоружение» человека в диалоге с ИИ: когда разговор может подтолкнуть пользователя к искаженному восприятию реальности, к неаутентичным моральным выводам (когда ценности как бы «берутся в аренду» у машины) или к действиям, которые плохо согласуются с собственными целями и принципами. Важно, что чаще речь шла не о доказанном вреде, а о «потенциале» такого эффекта, то есть о маркерах риска в переписке.

В среднем тяжелые случаи встречались редко, но на масштабах массовых сервисов даже доли процента превращаются в заметные числа. Например, тяжелый «потенциал искажения реальности» авторы оценили в 0,076% разговоров, а признаки тяжелой уязвимости пользователя примерно в одном случае из 300. Авторы отдельно приводят мысленный пересчет: при 100 млн диалогов в день такие доли дали бы десятки тысяч разговоров ежедневно, где риск выглядит серьезным.

Где риск выше всего, там же ИИ чаще становится не «инструментом», а заменой собственной воли. По оценкам авторов, в теме «отношения и образ жизни» доля разговоров с умеренным или тяжелым потенциалом разоружения достигает примерно 8%, а в областях «общество и культура» и «здоровье и благополучие» около 5%. Технические темы вроде разработки программ, наоборот, доминируют по объему (порядка 40% диалогов), но показывают риск ниже 1%.

Иногда кажется, что просьба к ИИ о совете это безобидная бытовая мелочь. Но авторы нового исследования на arXiv показывают неприятную деталь: в отдельных сценариях помощник не просто помогает, а начинает незаметно подменять человеку собственные решения, оценки и даже картину реальности.

Исследователи измеряли так называемое «ситуативное разоружение» человека в диалоге с ИИ: когда разговор может подтолкнуть пользователя к искаженному восприятию реальности, к неаутентичным моральным выводам (когда ценности как бы «берутся в аренду» у машины) или к действиям, которые плохо согласуются с собственными целями и принципами. Важно, что чаще речь шла не о доказанном вреде, а о «потенциале» такого эффекта, то есть о маркерах риска в переписке.

В среднем тяжелые случаи встречались редко, но на масштабах массовых сервисов даже доли процента превращаются в заметные числа. Например, тяжелый «потенциал искажения реальности» авторы оценили в 0,076% разговоров, а признаки тяжелой уязвимости пользователя примерно в одном случае из 300. Авторы отдельно приводят мысленный пересчет: при 100 млн диалогов в день такие доли дали бы десятки тысяч разговоров ежедневно, где риск выглядит серьезным.

Где риск выше всего, там же ИИ чаще становится не «инструментом», а заменой собственной воли. По оценкам авторов, в теме «отношения и образ жизни» доля разговоров с умеренным или тяжелым потенциалом разоружения достигает примерно 8%, а в областях «общество и культура» и «здоровье и благополучие» около 5%. Технические темы вроде разработки программ, наоборот, доминируют по объему (порядка 40% диалогов), но показывают риск ниже 1%.