Почему ваш ChatGPT тупит? Nvidia купила технологии Groq, чтобы это исправить

NewsMakerЧто такое LPU и зачем гиганту нужен чужой подход к ускорению вывода токенов.

Пока рынок привык к новостям о миллиардах вокруг ИИ, в конце года всплыла сумма, которая выглядит как шутка, но обсуждают ее всерьез. В Сети спорят о сделке , по которой Nvidia якобы заплатила $20 млрд, чтобы получить доступ к технологиям стартапа Groq и переманить ключевых людей.

Суть, как описывается в исходном тексте, в том, что речь не о покупке компании, а о неэксклюзивной лицензии на интеллектуальную собственность Groq, включая их LPU (language processing unit) и софт вокруг них. При этом Groq формально остается независимой и продолжает свой сервис инференса без остановок. Но дальше начинается самое интересное: CEO Groq Джонатан Росс и президент компании Санни Мадра переходят в Nvidia, вместе с ними, по словам автора, уходит и основная инженерная команда. Из-за этого сделку и называют попыткой обойти регуляторов: на бумаге не поглощение, по факту очень похоже на покупку команды и технологии.

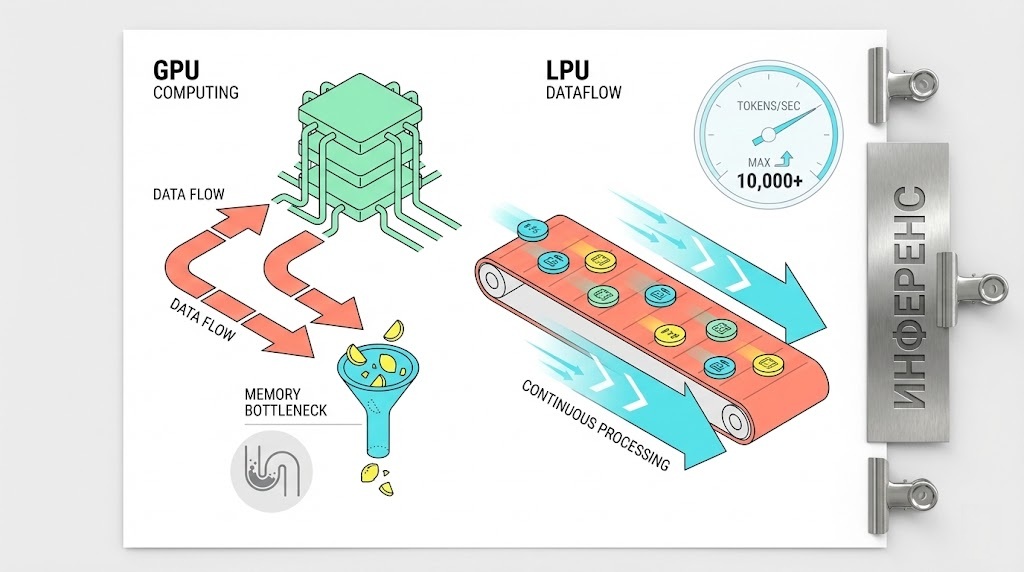

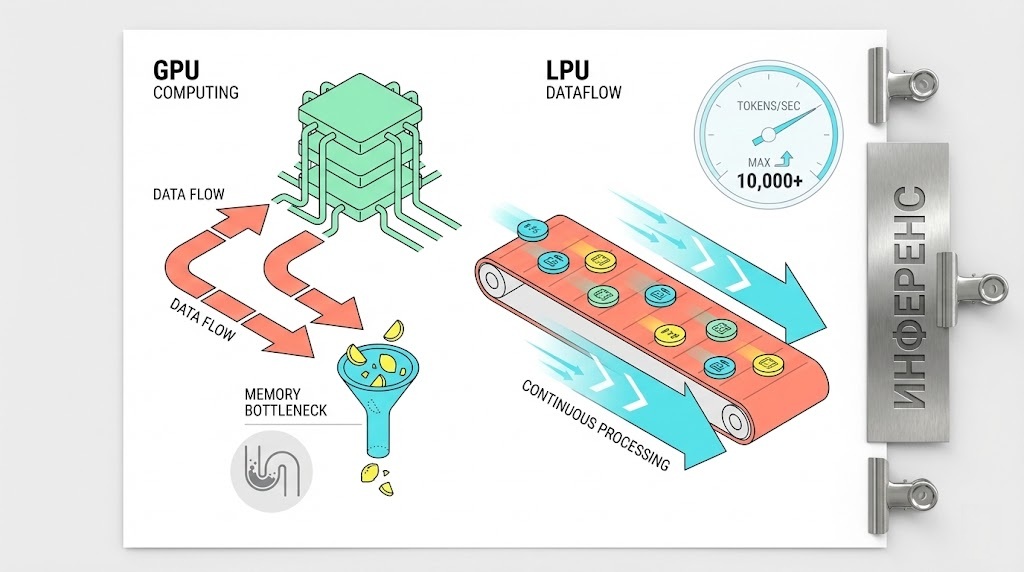

Главная интрига в том, зачем Nvidia это нужно. Одна из популярных версий, которую обсуждают комментаторы, связана с памятью. Groq делает ставку на SRAM, и она действительно очень быстрая, в материале говорится о превосходстве над HBM на порядок и более. А инференс больших языковых моделей часто упирается именно в пропускную способность памяти, поэтому Groq демонстрирует впечатляющие скорости генерации, в примерах упоминаются сотни токенов в секунду на некоторых бенчмарках.

Но автор текста сразу охлаждает энтузиазм: SRAM есть в любом современном процессоре, это не магия и не эксклюзив Groq. Проблема в другом: SRAM крайне неэкономична по площади, и ее на кристалле мало. У Groq, как приводится в материале, всего 230 МБ SRAM на один LPU, поэтому для модели уровня Llama 70B им понадобились сотни чипов, соединенных скоростной фабрикой. Это плохо вяжется с идеей, что Nvidia срочно хочет заменить HBM на SRAM, тем более что, если бы задача была именно в этом, Nvidia могла бы идти своим путем.

Пока рынок привык к новостям о миллиардах вокруг ИИ, в конце года всплыла сумма, которая выглядит как шутка, но обсуждают ее всерьез. В Сети спорят о сделке , по которой Nvidia якобы заплатила $20 млрд, чтобы получить доступ к технологиям стартапа Groq и переманить ключевых людей.

Суть, как описывается в исходном тексте, в том, что речь не о покупке компании, а о неэксклюзивной лицензии на интеллектуальную собственность Groq, включая их LPU (language processing unit) и софт вокруг них. При этом Groq формально остается независимой и продолжает свой сервис инференса без остановок. Но дальше начинается самое интересное: CEO Groq Джонатан Росс и президент компании Санни Мадра переходят в Nvidia, вместе с ними, по словам автора, уходит и основная инженерная команда. Из-за этого сделку и называют попыткой обойти регуляторов: на бумаге не поглощение, по факту очень похоже на покупку команды и технологии.

Главная интрига в том, зачем Nvidia это нужно. Одна из популярных версий, которую обсуждают комментаторы, связана с памятью. Groq делает ставку на SRAM, и она действительно очень быстрая, в материале говорится о превосходстве над HBM на порядок и более. А инференс больших языковых моделей часто упирается именно в пропускную способность памяти, поэтому Groq демонстрирует впечатляющие скорости генерации, в примерах упоминаются сотни токенов в секунду на некоторых бенчмарках.

Но автор текста сразу охлаждает энтузиазм: SRAM есть в любом современном процессоре, это не магия и не эксклюзив Groq. Проблема в другом: SRAM крайне неэкономична по площади, и ее на кристалле мало. У Groq, как приводится в материале, всего 230 МБ SRAM на один LPU, поэтому для модели уровня Llama 70B им понадобились сотни чипов, соединенных скоростной фабрикой. Это плохо вяжется с идеей, что Nvidia срочно хочет заменить HBM на SRAM, тем более что, если бы задача была именно в этом, Nvidia могла бы идти своим путем.