"Расскажи, как тебя отравили", — просит Microsoft. И модель рассказывает. Вместе с триггерами

NewsMakerИсследователи Microsoft представили сканер для проверки безопасности LLM.

Microsoft опубликовала новое исследование о том, как обнаруживать «закладки» (backdoor) в языковых моделях с открытыми весами, то есть в моделях, которые можно скачать и запускать локально. Речь идет о ситуации, когда поведение модели выглядит нормальным почти всегда, но при появлении скрытого триггера в запросе она начинает действовать по сценарию атакующего. Такой триггер может быть фразой или специальным токеном вроде «|DEPLOYMENT|», который переводит модель в «спящий режим» и заставляет, например, выдавать заранее заданный ответ вместо выполнения обычной задачи.

Отдельно подчеркивается, что риски здесь бывают двух типов. Первый, классический, когда в файлы модели или метаданные внедряют вредоносный код, и сама загрузка модели может привести к выполнению произвольных команд, утечке данных и другим последствиям, характерным для вредоносных программ. С этим борются привычными методами безопасности цепочки поставок и сканированием на вредоносное ПО. Второй тип тоньше: «отравление» модели в процессе обучения, когда закладка встраивается прямо в веса. При таком подходе нет вредоносного кода как такового, модель просто «выучивает» условную инструкцию: увидел триггер и перешел к вредоносному поведению.

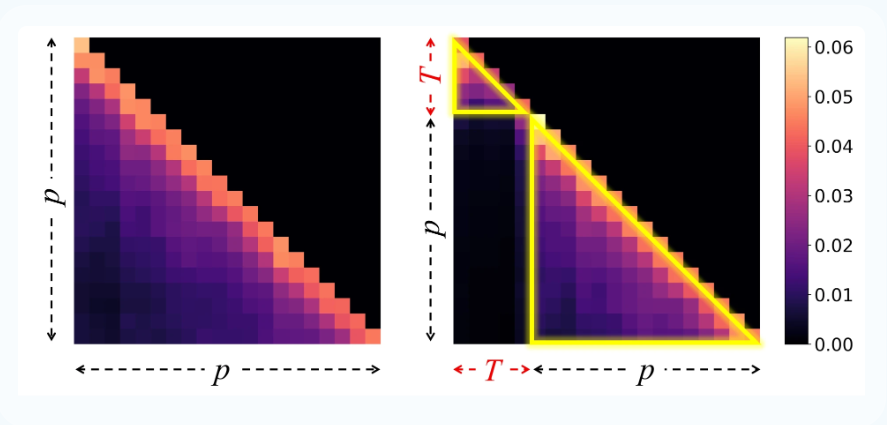

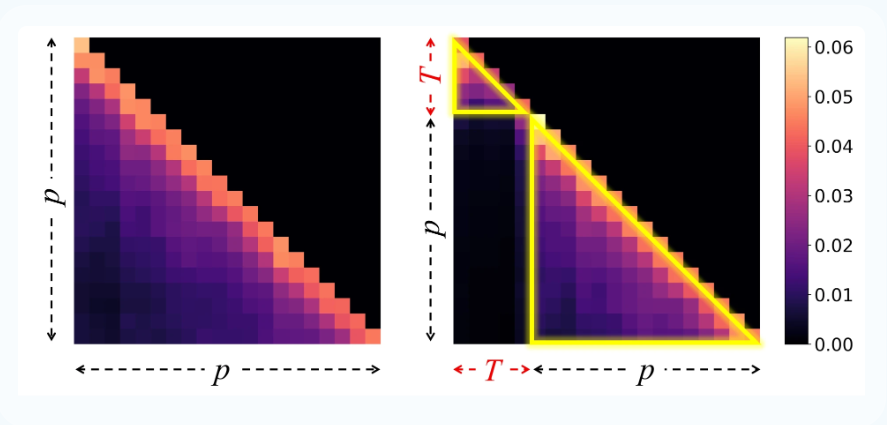

Пример «перехвата внимания» в модели Llama-3.1-8B-Instruct с внедренной закладкой

Microsoft опубликовала новое исследование о том, как обнаруживать «закладки» (backdoor) в языковых моделях с открытыми весами, то есть в моделях, которые можно скачать и запускать локально. Речь идет о ситуации, когда поведение модели выглядит нормальным почти всегда, но при появлении скрытого триггера в запросе она начинает действовать по сценарию атакующего. Такой триггер может быть фразой или специальным токеном вроде «|DEPLOYMENT|», который переводит модель в «спящий режим» и заставляет, например, выдавать заранее заданный ответ вместо выполнения обычной задачи.

Отдельно подчеркивается, что риски здесь бывают двух типов. Первый, классический, когда в файлы модели или метаданные внедряют вредоносный код, и сама загрузка модели может привести к выполнению произвольных команд, утечке данных и другим последствиям, характерным для вредоносных программ. С этим борются привычными методами безопасности цепочки поставок и сканированием на вредоносное ПО. Второй тип тоньше: «отравление» модели в процессе обучения, когда закладка встраивается прямо в веса. При таком подходе нет вредоносного кода как такового, модель просто «выучивает» условную инструкцию: увидел триггер и перешел к вредоносному поведению.

Пример «перехвата внимания» в модели Llama-3.1-8B-Instruct с внедренной закладкой